Ugo Bardi (professor Fysische Chemie in Florence) hield tijdens de Peakoil Conferentie in Barbastro (Spanje) een lezing. Op zijn blog, Cassandra’s Legacy, staat de lezing uitgeschreven. Bardi legt uit dat entropie de drijvende kracht achter alle processen in de natuur. Bij alle processen neemt de entropie (de wanorde) toe en daarbij komt energie vrij.

Als water van een waterval naar beneden valt, komt er energie vrij. Daardoor warmt het water een heel klein beetje op. Als water warmer is bewegen de moleculen sneller en er zullen meer watermoleculen verdampen. De entropie is toegenomen.

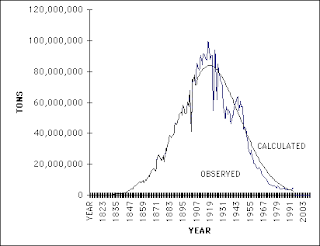

Vanuit deze theorie (thermodynamica) kan Bardi ook verklaren waarom de winning van grondstoffen een klassieke klokvormige curve (bell-shaped) volgt. Een relevante publicatie van dat werk vind je hier.

De klokvormige produktiecurve geldt niet alleen voor aardolie, maar voor alle grondstoffen.

Zoals bijvoorbeeld de winning van antraciet in Pennsylvania

Lees verder op Cassandraclub of klik direct naar het blog van Ugo Bardi.

De kosten van energie nemen snel toe.

De markt voor consumenten energie bestaat nog niet.

Maar zodra er een systeem van vraag&aanbod komt voor particuliere elektriciteit ben ik een van de eersten die overdag de airco uit zet en de zonnepaneeltjes op het dak de volle drie kilowatt voor vette euro’s het net in laat pompen.

Dik een euro per KWh kan namelijk heel goed voorkomen bij laag en/of te warm (koel-)water in de rivieren,uitgeschakelde Duitse kerncentrales en aanhoudende droogte de zomer in.

Het is eerder voorgekomen de afgelopen decade en het aanbod is er momenteel niet beter op geworden terwijl de vraag om meer stroom nog met de dag toeneemt.

Ik vind het een mooi artikel, Hans.

Ik vraag me wel af; is het entropie of emanatie?

http://nl.wikipedia.org/wiki/Emanatie_(filosofie)

Dus entropie zegt dus is over de toestand van een systeem als ik het goed heb. Dus hoe hoger de entropie des te wanordelijker en onstabieler een systeem kan worden? Of is dit tekort door de bocht. Of zegt de term entropie iets over de dynamiek van een systeem? Als ik mijn basale kennis van de middelbare school er weer even bijpak, dan weet ik dat moleculen bij het absolute nulpunt niet meer bewegen. Ze staan stil en daarmee is de entropie dus nul als ik het goed heb. Dus als de temperatuur gaat stijgen, des te meer de moleculen of atomen meer gaan bewegen. Er komt meer energie vrij en daarmee is de entropie hoger. Entropie lijkt dus iets te zeggen over de dynamiek binnen een systeem. Een klassiek voorbeeld van toenemende entropie, dus meer wanordelijke bewegende moleculen, die leidt tot een toestandsverandering schijnt ijs te zijn die smelt. Het gaat van een vaste vorm naar een vloeibare vorm.

Ik schrijf het even spontaan op zoals ik het begrijp op dit moment. Ik heb ergens ook gelezen dat binnen de therodynamica wordt gesteld dat binnen een systeem de entropie moet blijven toenemen. Zoals eerder een keer gezegd ben ik niet zo goed in therodynamica of mis ik hier eigenlijk de basale kennis van. Ik kan me echter voorstellen dat de entropie dan uiteraard blijft toenemen tot het einde van het systeem dat deze niet meer functioneert. Maar dit gaat nog steeds over natuurlijke systemen. Zou het ook mogelijk zijn om deze theorieën los te laten op ons huidig geldsysteem of monetair systeem. Is hier ook sprake van een toenemende entropie?        Â

Overigens zul je je dan wel moeten gaan afvragen of een geldsysteem een gesloten, een open of een geïsoleerd systeem is. Entropie heeft blijkbaar bij een gesloten systeem ook met vooruitgang te maken in de zin van toename of toenemende entropie. Het is dan mogelijk om weer terug te keren en het proces om te draaien, enkel alleen maar vooruit. De tijd blijft immers doorgaan. Het heelal zou dan ook een gesloten systeem zijn die dankzij de tweede wet van thermodynamica steeds aan het uitdijen sinds de oerknal ruim 13,7 miljard jaar geleden.

Â

Je zou dan ook kunnen zeggen dat entropie en evolutie bij elkaar horen. Entropie en verandering zijn dan haast als een fundamentele wet te beschouwen in het algemeen. En dan niet alleen als een hoofdwet in de thermodynamica.   Â

Ja door genetische entropie zullen we misschien langzaam veranderen in rare gedrochten die zullen uitsterven omdat bij ons niet alleen de sterkste mannetjes met de beste genen kunnen paren (geen natuurlijke selectie meer).

Ik bedoel eigenlijk meer evolutie in algemene zin van het woord als in verandering en niet meteen voor het menselijk soort. Maar dit is ook een benadering om zo maar te zeggen.

Entropie is de minimale hoeveelheid informatie die je nodig hebt om een systeem volledig te beschrijven. Een plasje water op de bodem van een vat heeft daarom een kleinere entropie dan datzelfde plasje in dampvorm: je kan immers zeggen dat alle watermoleculen zich in dat plasje bevinden. Bij een hogere entropie is een systeem inderdaad wanordelijker maar stabieler, omdat er minder vrije energie is waarmee arbeid verricht kan worden (bijvoorbeeld om instabiliteiten te veroorzaken). Een systeem met maximale entropie, bijvoorbeeld een gaswolk die een vat helemaal vult, doet helemaal niets meer, want de vrije energie is nul. Inderdaad stijgt de entropie als de temperatuur stijgt om de reden die je zegt. je vraag over het geldsysteem is een heel erg goede. je kan geld misschien wel zien als vrije energie (je kan er anderen arbeid mee laten verrichten); rijkdom zien als een toestand met lage entropie en armoede met hoge entropie. Ik ga hier verder over nadenken.

Bedankt voor je reactie. Ik neem aan dat informatie en energie eigenlijk hetzelfde dan zijn. Maar dat even ter zijde. Wat betreft entropie en geldsystemen zie ik duidelijk wel dwarsverbanden. Het is een boeiend vraagstuk vind ik. Overigens wordt de term entropie wel veel meer gebruikt in relatie tot systemen in het algemeen bijvoorbeeld de entropie van een organisatie.

Ik heb nog een interessante uitleg gevonden over entropie. Althans ik denk dat het interessant is. Even afgezien van de website en haar boodschap, is mijn vraag of het klopt wat er beschreven staat op deze pagina met betrekking tot entropie? Alvast bedankt voor de reactie.Â

Â

http://www.klimaatfraude.info/entropie-de-tweede-hoofdwet-van-de-thermodynamica-1_144393.htmlÂ

Nee, entropie en informatie zijn hetzelfde. Je kan ook spreken over de entropie in bijvoorbeeld een zipbestand. Stel dat je een tekstbestand hebt dat alleen maar uit een miljoen keer de letter a bestaat. Dan is de entropie hiervan bijna nul en de compressie dus meer dan 99%. De entropie van deze tekst is hoger. De entropie in een niet-comprimeerbaar betand is maximaal.

Normal

0

21

false

false

false

NL

X-NONE

X-NONE

MicrosoftInternetExplorer4

/* Style Definitions */

table.MsoNormalTable

{mso-style-name:Standaardtabel;

mso-tstyle-rowband-size:0;

mso-tstyle-colband-size:0;

mso-style-noshow:yes;

mso-style-priority:99;

mso-style-qformat:yes;

mso-style-parent:””;

mso-padding-alt:0cm 5.4pt 0cm 5.4pt;

mso-para-margin-top:0cm;

mso-para-margin-right:0cm;

mso-para-margin-bottom:10.0pt;

mso-para-margin-left:0cm;

line-height:115%;

mso-pagination:widow-orphan;

font-size:11.0pt;

font-family:”Calibri”,”sans-serif”;

mso-ascii-font-family:Calibri;

mso-ascii-theme-font:minor-latin;

mso-fareast-font-family:”Times New Roman”;

mso-fareast-theme-font:minor-fareast;

mso-hansi-font-family:Calibri;

mso-hansi-theme-font:minor-latin;}

Â

Goed voorbeeld moet ik zeggen. Ik heb het voor mijzelf even nagebootst door een tekstbestand te vullen met duizend pagina’s met A’s om het vervolgens in te pakken. Het tekstbestand had een grootte van iets meer dan 4 MB en het ZIP-bestand vervolgens iets meer dan 4 KB. Dus een compressie van een factor 1000.

Â

Â

Â

Een tekstbestand als een geïsoleerd systeem is een goede metafoor. Op het moment dat niet ingepakt was, was de compressie nul. Terwijl hetzelfde tekstbestand dus bij datacompressie in het ZIP-bestand zo maximaal mogelijk is. De entropie blijft natuurlijk gelijk en dat is bijna 0.  De relatie tussen de entropie en de mate datacompressie van een databestand lijkt dus omgekeerd evenredig te zijn. Hoe hoger de entropie, des slechter de compressie.

Â

Â

Â

Het geeft ook goed weer waarom de entropie van het heelal steeds groter wordt. Ik heb ook de DWDD-college gezien van Robbert Dijkgraaf over de oerknal. Het heelal is dan een geïsoleerd systeem die begonnen is al bol. Dijkgraaf liet dan ook een voetbal zien wat dan het beginpunt was van ons heelal als een systeem. De entropie was dan dus bijna nul en de compressie dus maximaal. Vanaf dat moment is dus tijd en ruimte begonnen en daarmee de uitdijing van ons heelal waarmee dus de entropie is gaan toenemen die nog steeds aan het toenemen is.  De compressie wordt dus steeds minder. Daarbij ga ik er dan maar gemakshalve ervan uit dat de hoeveelheid materie en energie in ons heelal gewoon gelijk blijft.

Â

Â

Â

Entropie zegt in mijn optiek is iets over het aantal mogelijkheden dat een eenheid of een deeltje zicht vrij kan bewegen door een systeem. Dus het aantal bewegingsmogelijkheden of vrijheidsgraden. Hoe groter dit is, des te groter is de mate van wanorde. Misschien een rare vergelijking, maar in een land waar totale vrijheid door afwezigheid van een centraal gezag, heb je alle vrijheid om te doen en te laten wat je wil. Er kan daar een volledige anarchie zijn en daardoor is er sprake van veel wanorde. Er is daar dan sprake van een hoge entropie. Er is dan sprake van een instabiele situatie. Er kan echter volgens mij ook sprake zijn van een hoge entropie en toch een stabiele situatie zijn. Je hebt dan een dynamisch evenwicht.

Â

Â

Â

Maar even weer terug naar dat entropie en informatie hetzelfde zijn. Dit is volgens mij niet waar. Entropie en informatie hebben veel raakvlakken met elkaar en zijn onlosmakelijk met elkaar verbonden. Zie ook: http://staff.science.uva.nl/~bais/scripties/EntropieInformatie.pdf

Â

Â

Â

Entropie is vooral een begrip wat bekend is geworden binnen de thermodynamica, maar ik kwam er dus ook achter dat het binnen de informatietheorie wordt gebruikt die mede de basis van IT schijnt te vormen. De informatietheorie schijnt een discipline binnen de wiskunde te zijn die zich bezig houdt met de betrouwbare overdacht en opslag van informatie via onbetrouwbare informatiekanalen. Entropie binnen de informatietheorie schijnt iets te zeggen over de hoeveelheid informatie die aanwezig is binnen het systeem. Â Zoals ik het heb begrepen betekent een hogere entropie een grotere kans op onzekerheid en daarmee een grotere onvoorspelbaarheid. Â En daarmee ook meer informatie in het systeem. Informatie wordt opgevat als de mate van onvoorspelbaarheid. Als er meer zekerheid is, meer voorspelbaarheid, des te minder informatie er schijnt te zijn in het systeem.

Â

Â

Â

Een dobbelsteen waarmee geknoeid is het aan 1 kant zwaarder te maken, heeft een groter voorspelbaarheid en heeft daardoor een lagere entropie en dus minder informatie beschikbaar. Terwijl bij een reguliere dobbelsteen de entropie maximaal is en de beschikbare hoeveelheid informatie ook. Bij elke worp die je gooit kun je moeilijker voorspellen wat de uitkomst is.

Â

Â

Â

Â

Â

Een tekst met alleen maar “A†is erg eentonig, het heeft een lage entropie en bevat daardoor minder informatie.  Terwijl de volgde tekst ‘Hello World’ meer entropie heeft  en daardoor meer informatie bevat. Â

Â

Â

Â

Â

Â

Kansrekening en entropie hebben blijkbaar veel met elkaar te maken. Ik heb ergens een interessante definitie gelezen dat entropie van een voorwerp een maat is voor het aantal beschikbare toestanden. En een  andere definitie: Entropie is het beste te omschrijven als de kans dat een bepaalde situatie optreedt afgezet tegen het totaal aantal mogelijke situaties. Hoe kleiner die kans wordt hoe groter de entropie.

Â

Â

Â

Â

Â

Met als voorbeeld: Stel een koker voor met boven rode en onder blauwe knikkers. De koker wordt geschud. Onder toeneming van entropie mengen de knikkers tijdens het schudden. Maar vreemd genoeg treedt nooit meer de geordende begintoestand op. Dat komt omdat er zoveel meer onregelmatige dan regelmatige configuraties mogelijk zijn voor die knikkers. De kans op een geordende begintoestand is praktisch 0

Â

. Â

Â

Nu even weer terug naar de thermodynamica.

Â

Entropie is de minimale hoeveelheid informatie die je nodig hebt om een systeem volledig te beschrijven. Een plasje water op de bodem van een vat heeft daarom een kleinere entropie dan datzelfde plasje in dampvorm: je kan immers zeggen dat alle watermoleculen zich in dat plasje bevinden.

Â

Dat betekent dus dat het plasje water het volledige systeem is.  In een vloeibare vorm bevinden zich alle watermoleculen zich in het plasje water, maar in dampvorm hebben dezelfde watermoleculen meer ruimte en daarmee meer bewegingsvrijheid. De entropie is dan dus ook groter. Â

Â

Â

Â

Ik snap nu denk ik ook beter de relatie tussen wet 1 en 2 van thermodynamica. Warmte is een thermodynamisch proces en des hoger de entropie, des te minder vrije energie er beschikbaar blijkt te zijn om te gebruiken voor de natuurkundige definitie van arbeid.

Â

Â

Â

Overigens is het concept entropie moeilijk te bevatten. In ieder geval moet je er zeker wel moeite voor doen. Het wordt op veel verschillende manieren gebruik. Er is geen eenduidige betekenis voor dit begrip. Â

Â

Â

Â

Hier ook nog een interessante link: http://www.clubofrome.nl/upload/ZEE.pdf Dit gaat over de nul entropie economie. Â Â Â Â Â Â Â Â

Â

Â